Singh, Gaurav, Meiqing Wu, and Siew-Kei Lam. “Fusing Semantics and Motion State Detection for Robust Visual SLAM.” In 2020 IEEE Winter Conference on Applications of Computer Vision (WACV), 2753–62. Snowmass Village, CO, USA: IEEE, 2020. https://doi.org/10.1109/WACV45572.2020.9093359.

1 Introduction

作者将语义信息和物体的运动状态融合到一个概率框架中,进行准确鲁棒的动态区域检测,为位姿估计和制图保留可靠的特征点。本算法包括以下步骤:

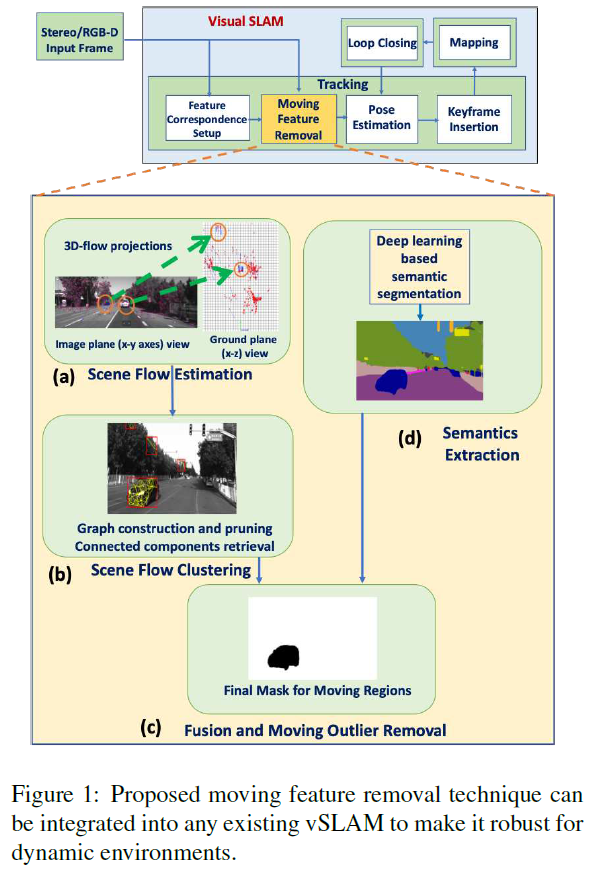

- 首先,利用一个轻量级的场景流估计和聚类方法来提取场景中的动态区域;

- 然后,利用语义分割提取场景的语义信息;

- 最后,为了解决前两步获取的动态区域和语义信息的不确定性,本算法使用一个概率框架来融合两个信息,来实现对移动区域的鲁棒检测。

这里,作者不使用RANSAC 算法,因为该算法无法应对动态物体占据主要区域的情况;作者使用一个基于图的方法来检测几何移动区域。

3 Proposed Method

本文提出算法的架构如Fig.1所示:

3.1 Sparse Scene Flow based Segmentation

3.1.1 Sparse Scene Flow Estimation

作者使用viso2 特征来计算相邻帧之间的2D 光流,以及双目相机之间的视差。

3.2 Semantic Segmentation

作者使用语义信息作为额外的线索来对物体的状态进行最终确认,为了进行横向对比,作者使用SegNet 进行语义分割,结合语义信息,上节获取的移动聚类区域只有位于可移动物体区域内的才可被视为是移动的。使用AND 或 OR 策略来融合几何信息和语义信息会造成比较大的误差:OR 策略会导致大量静态特征点被错误判定为静态点,而AND 策略会保留部分动态特征点。为了避免这种简单的融合策略,作者提出使用概率模型来对两种信息进行鲁棒融合。

3.3 Fusion of Geometric and Semantic methods

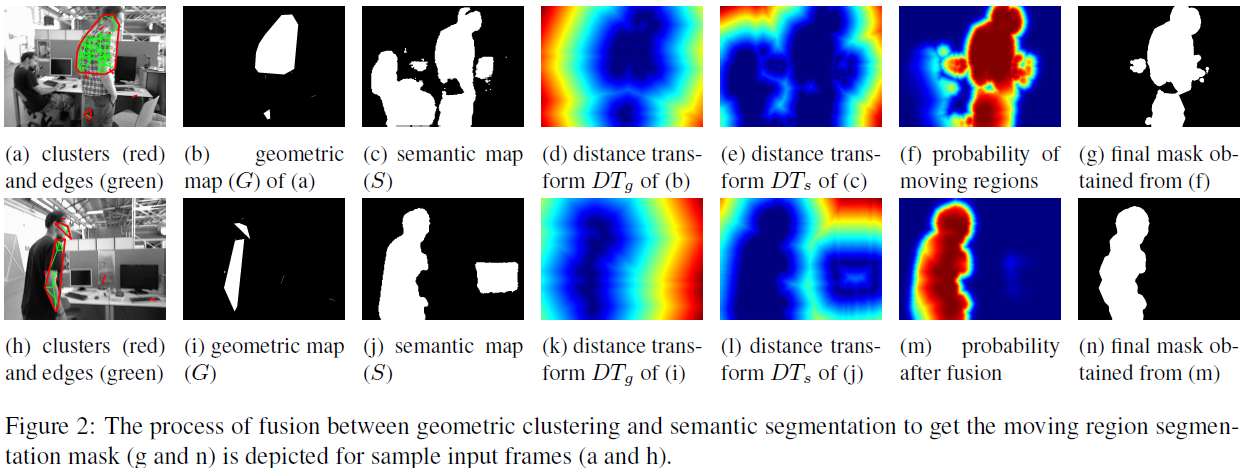

基于几何聚类获取的场景流可以检测出图片中的移动区域,如Fig.2(a)所示,并将其转化为掩码图片 G,如(b)所示;同样地,作者将语义分割中的潜在动态物体转化为掩码图片 D,如(c)所示。

作者认为不能直接根据G 和 S 来对动态区域进行判断,而是引入了概率模型,作者使用(Lianos 等, 2018)中提到的distance transform 方法来将G、S转换至一个距离地图中,并使用高斯模型来估计移动概率;该概率模型考虑了不确定度,使得G、S可以进行鲁棒融合。

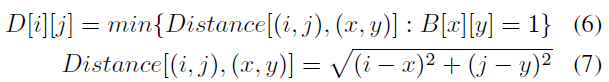

对于几何观测掩码图 G,使用欧氏距离作为距离尺度来构建距离地图 $DT_g$ :

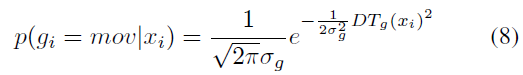

其中,B 表示掩码图。基于距离图 $DT_g$ 定义像素点 $x_i$ 属于动态区域的概率:

其中,$\sigma_g$ 表示基于几何分割的场景光流的不确定性。

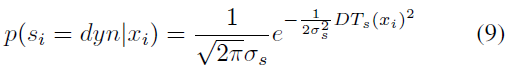

同样地,可以确定语义分割掩码图中像素点 $x_i$ 属于动态区域的概率:

其中,$\sigma_s$ 表示语义分割的不确定度。

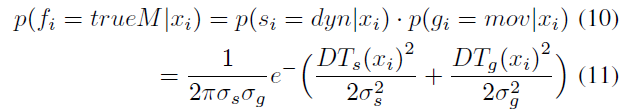

因为语义分割S 和基于场景流的几何分割G 是独立估计的,所以可以将两种估计进行融合来减少不确定度,以此获取移动区域似然:

两者融合后的概率图如Fig.2(f)所示,其中 $\sigma_s = 40 pixels, \sigma_g = 80 pixels$ 。根据设定的移动概率阈值,得到最终的动态区域,如(g)所示。

概率融合来确定动态区域的优势在于可以将两种检测方式(几何和语义)进行优势互补、效果增强,如(b)中几何方法无法实现对完整动态物体的检测,(c)中语义信息无法确定先验动态物体的真正运动状态,(j)中可消除错误分类的影响。

4 Experiments

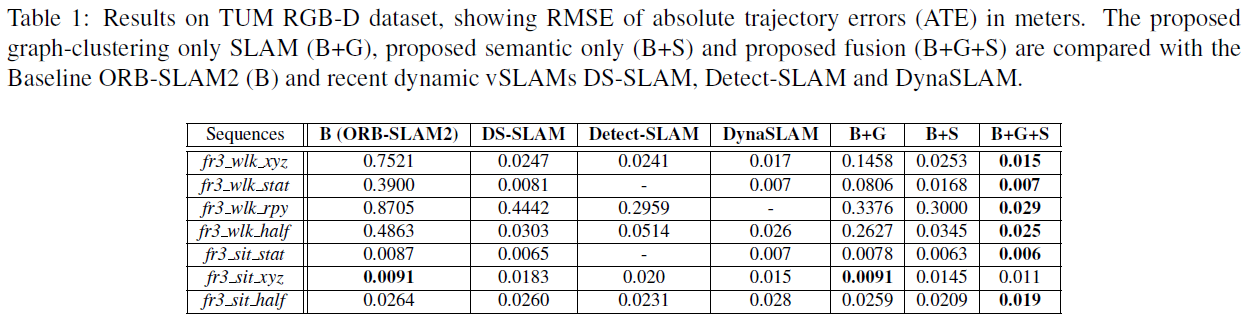

在TUM 数据集上的测试结果:

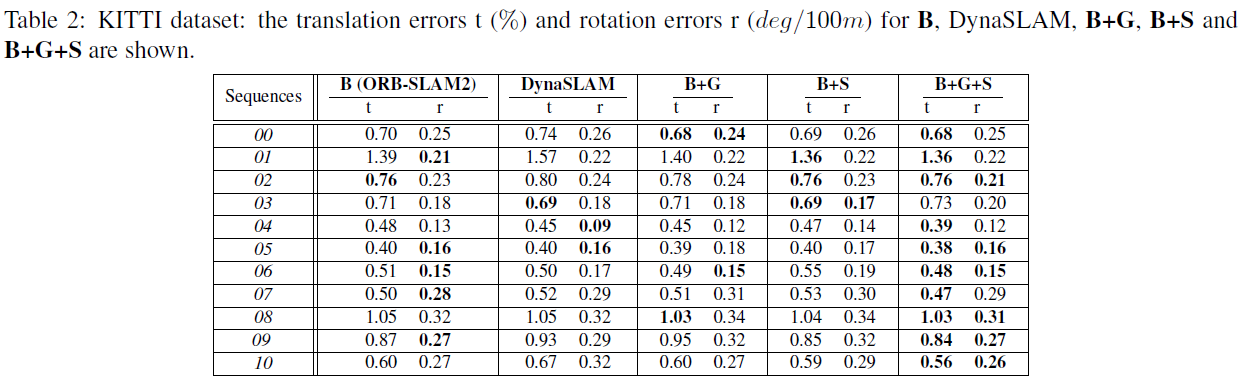

在KITTI 数据集上的测试结果: