Wang, Yutong, Chaoyang Jiang, and Xieyuanli Chen. “VOOM: Robust Visual Object Odometry and Mapping Using Hierarchical Landmarks.” arXiv, February 26, 2024. https://doi.org/10.48550/arXiv.2402.13609.

Abstract

作者提到,物体SLAM 可以在保证计算效率的同时提供高等级的语义信息,部分研究者将建模的物体观测残差添加进BA 中进行位姿优化,但由于物体模型的精度问题,导致优化效果不如基于特征点的方法。基于此,作者提出了一种视觉物体里程计和制图架构——VOOM (Visual Object Odometry and Mapping),该架构不直接将观测物体残差添加进BA 中,而是使用一种由粗到细的方式将高等级物体和低等级特征点作为层级地标观测。

1 Introduction

作者认为,本方法是第一个利用对偶二次曲面和特征点实现比基于特征点的SOTA SLAM 算法更好定位精度的物体SLAM 算法。

本文的贡献如下:

- 提出了一种新颖的视觉里程计和制图架构,该架构同时使用特征点和对偶二次曲面作为地标;

- 提出了一种有效的算法,使用层级地标进行物体优化、物体关联和基于物体的地图点关联,以进行地图构建;

- 大量实验证明了本算法较SOTA 算法的优越性。

3 VOOM

3.1 System Overview

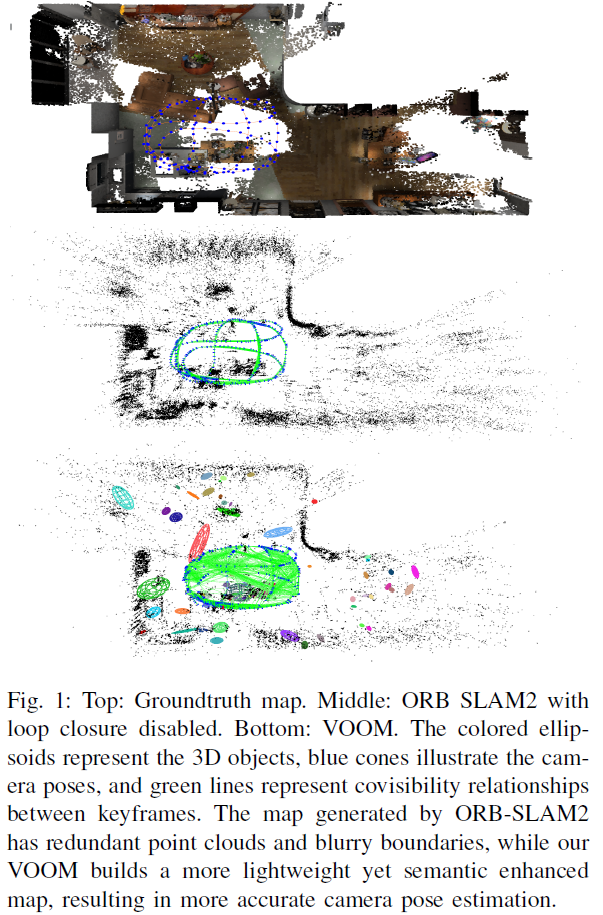

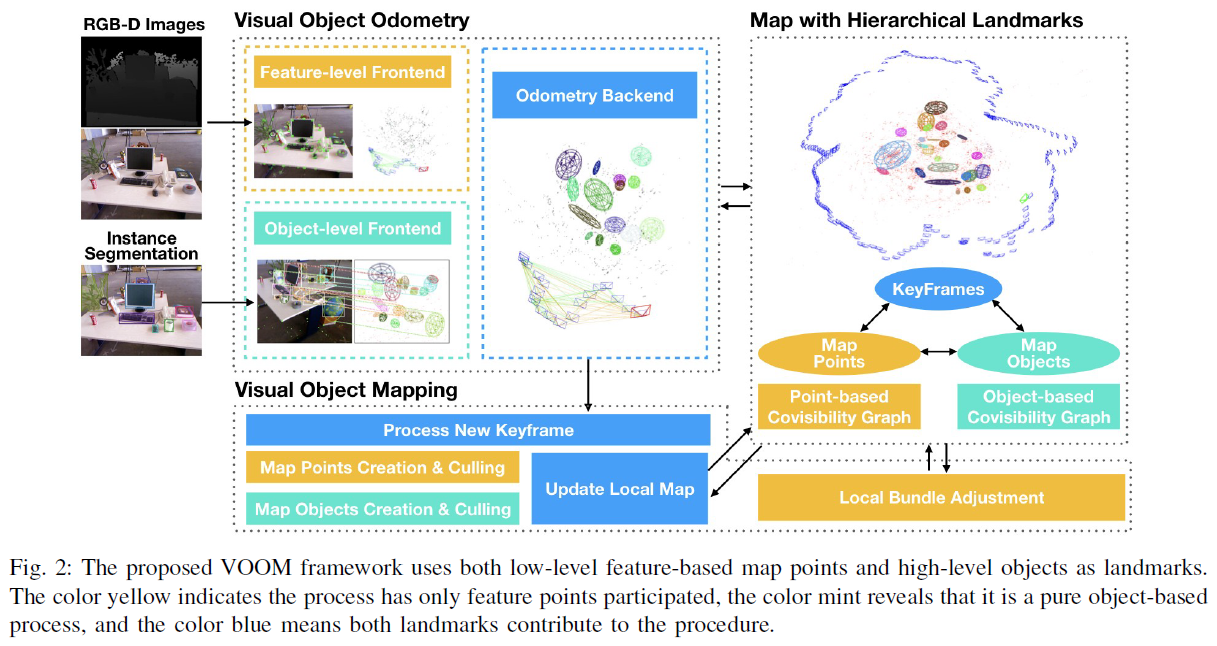

VOOM 系统以RGB-D 图片为输入,输出包含地图点和3D 物体的3D 地图。整体架构如Fig. 2所示,包含两个主要部分:视觉物体里程计和视觉物体建图。

系统的实例分割采用YOLOv8 网络进行处理,特征点部分是基于ORB-SLAM2 算法构建的。在物体级前端,基于实例分割获取的特征点,使用direct least squares 直接最小二乘法来估计椭圆形;物体级数据关联是基于3D 物体重投影与估计椭圆之间的Wasserstein distance 进行的。

3.2 Observation Model of Objects

VOOM 对每张输入图片进行实例分割,QISO-SLAM (Wang 等, 2023)中提到,使用实例分割的轮廓线会比使用bbox 实现更高精度的物体建图与定位;基于此,作者对于第 f 张图片上的第 k 个物体,通过最小化所有分割轮廓点和椭圆边界的最小距离和来估计物体的椭圆观测 $E_{fk}^{obs}$ 。

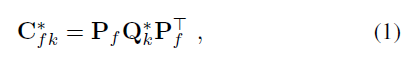

作者使用受限对偶二次曲面 $Q_k^\ast \in \mathbb{R}^{4 \times 4}$ 来表示物体,投影至图像平面后表示为对偶二次曲线:

其中,$\mathbf{P}_f = \mathbf{K}_f[\mathbf{R}_f | \mathbf{t}_f^T] \in \mathbb{R}^{3 \times 4}$ 为相机投影矩阵;$\mathbf{C}_{fk}^\ast$ 表示根据位姿估计得到的椭圆 $E_{fk}^{est}$ 。可根据 $E_{fk}^{obs}$ 和 $E_{fk}^{est}$ 构建相应的误差方程。

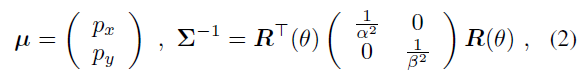

受到OA-SLAM (Zins 等, 2022)的启发,作者使用2D 高斯分布 $\mathcal{N}(\mu, \sum^{-1})$ 来表示椭圆:

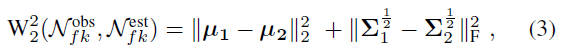

其中,$[p_x, p_y]^T, [\alpha, \beta]^T, \theta$ 分别表示椭圆的中心点、长短轴长度以及旋转角度。基于高斯分布,构建 $E_{fk}^{obs}$ 和 $E_{fk}^{est}$ 之间的二阶 Wasserstein distance 误差:

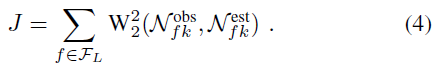

其中,$||.||_F$ 为F 范数。假设第k 个物体的观测帧集合为 $\mathcal{F}_L$ ,则该物体的椭球体参数可通过最小化下式来获取:

3.3 Object-level Data Association

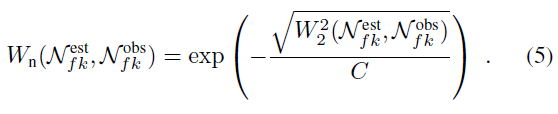

使用bbox 的IoU 进行物体级数据关联存在诸多问题,因此,作者使用归一化的 Wasserstein distance 进行数据关联,基于式3,可得到归一化的结果:

其中,C 是一个常数。该度量方式包含了椭圆的中心点、轴长度以及方向信息,要比bbox IoU 方法更为准确。

3.4 Coarse-to-fine Odometry and Mapping

主要出发点在于使用3D 物体地标的鲁棒性来提高特征点法的效率与精度。

3.4.1 Coarse-to-fine Visual Object Odometry Backend

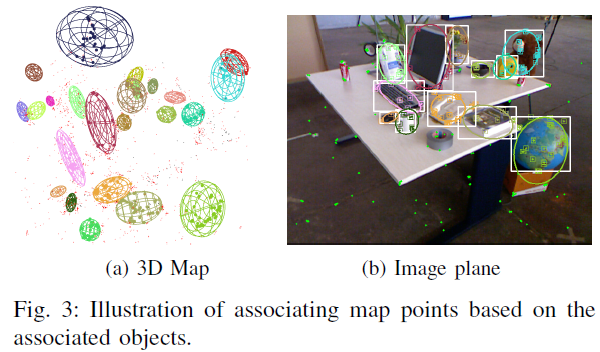

利用特征级前端的运动模型得到粗略的位姿估计,结合物体级前端的关联物体,算法在属于每个物体的地图点和关联物体实例中的特征点之间中搜寻匹配关系(基于ORB 特征描述子),如Fig. 3所示。

该方法通过减小搜索区域来实现更高效、更精准的地图点数据关联,并从更早的关联帧中恢复更多的地图点,而不是只能从最近的帧中进行关联。根据地图点和关键点之间的匹配,可基于重投影误差来优化相机位姿;然后,更新当前帧的local map,使用局部地图中更多的匹配关系对相机位姿进行进一步的优化。

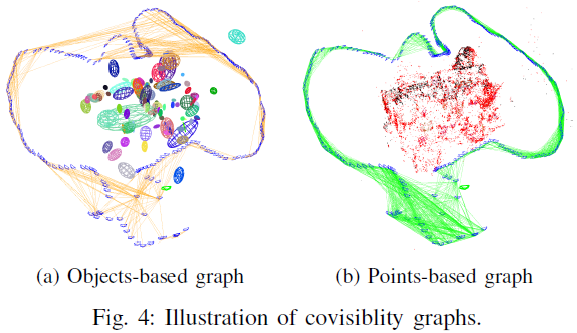

3.4.2 Coarse-to-fine Visual Object Mapping

在为当前帧获取了可靠的位姿估计和地图点关联之后,基于物体共视图 object covisibility graph 来更新局部地图,物体共视图记录了不同帧中不同物体间的公式关系,如Fig. 4(a)所示,这可以帮助选择一组与当前帧最相关的关键帧,与传统的共视图(Fig. 4 b)相比,物体共视图体积更小、鲁棒性更强。在物体共视图的帮助下,可以为当前帧建立与更早观测帧之间的关联,以此实现对位姿更高精度的优化效果。作者这里提到,由于物体的鲁棒性,仅使用local map 就可以实现类似回环检测的功能。

值得注意的是,由于物体建模的精确度问题,观测物体的残差不参与BA 优化。也就是说,物体在这里的作用仅在于增强帧之间特征点匹配的作用。

4 Experimental Results

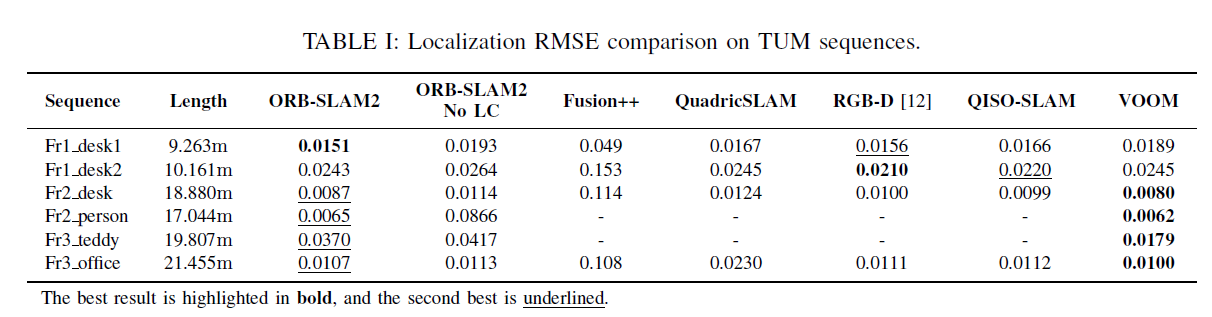

定位实验结果如表1所示: