Wang, Kai, Yimin Lin, Luowei Wang, Liming Han, Minjie Hua, Xiang Wang, Shiguo Lian, and Bill Huang. “A Unified Framework for Mutual Improvement of SLAM and Semantic Segmentation.” In 2019 International Conference on Robotics and Automation (ICRA), 5224–30. Montreal, QC, Canada: IEEE, 2019. https://doi.org/10.1109/ICRA.2019.8793499.

1 Introduction

本文的贡献 总结如下:

- 提出了一个同时增强vSLAM 和语义分割的统一框架;

- 通过识别并处理移动物体和潜在动态物体来增强制图与定位的精度;

- 提出一个利用3D 位姿来有效优化语义分割的策略。

3 Framework

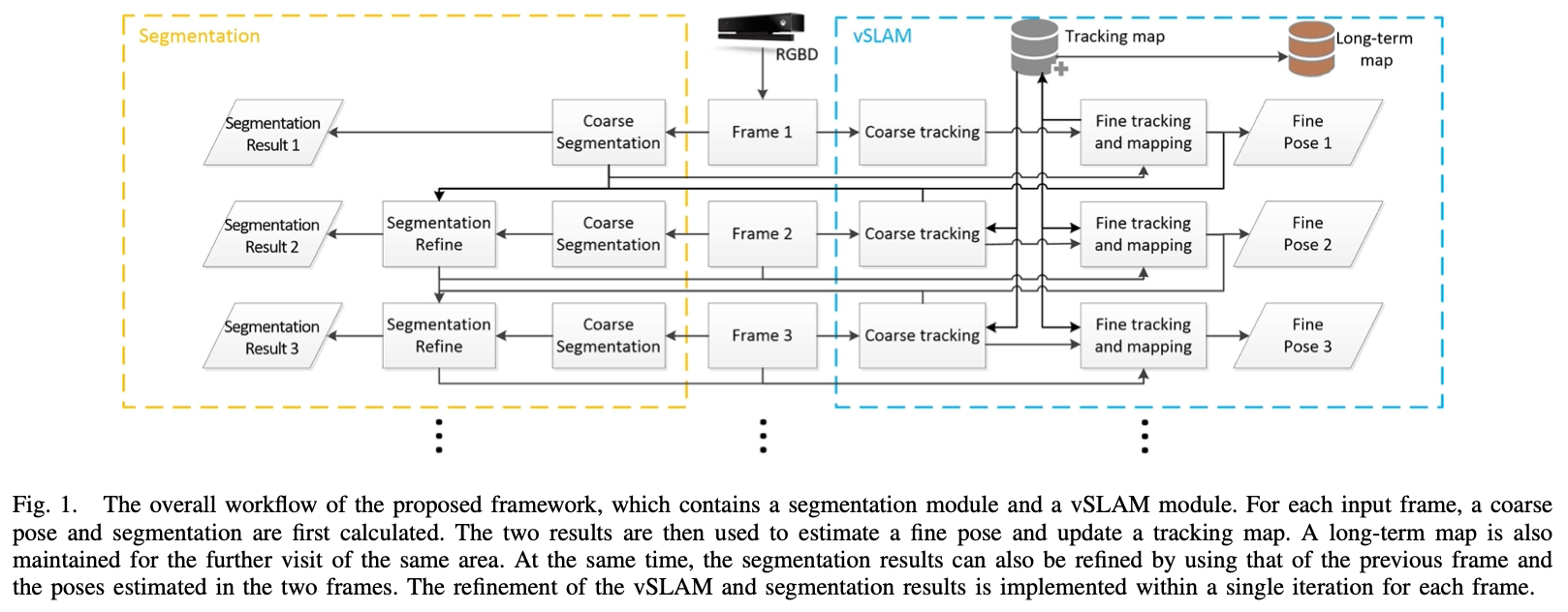

3.1 Overall Workflow

系统框架如图一所示,系统以RGBD 图像作为输入,主要包含两个模块:vSLAM 以及语义分割模块。

3.2 Initial Segmentation

本系统使用FCIS 进行初始化(粗糙coarse)分割,FCIS 可以计算每个物体的bbox,如果bbox 内的像素值the pixel value大于一定阈值,则被视为物体的一部分,否则被标记为背景。分割之后可以得到所有的先验动态物体。

3.3 vSLAM based on Segmentation Result

作者使用ORB-SLAM2来处理RGBD 图片。对于每一帧新的图片,提取ORB 特征并将其与深度图对齐以得到其3D 坐标,然后根据最小重投影误差计算初始(粗糙coarse)位姿估计。

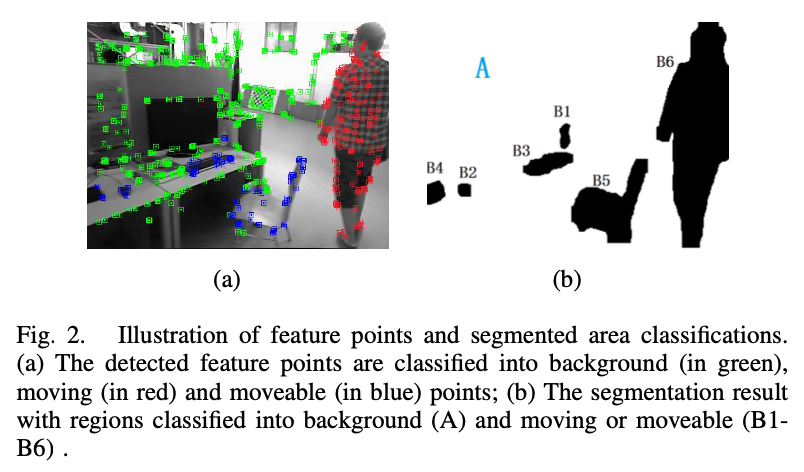

在初始位姿估计基础上来判断物体的运动状态:作者根据分割结果将图片像素分为A组:代表背景区域,$\{B_i|i=1…n\}$ 表示不同的物体区域;根据初始位姿估计,计算相应匹配点在当前帧中的投影位置,根据两者之间的欧式距离判断该点是否是动态特征点;若组 $B_i$ 内判定为动态特征点的数量超过一个阈值,则判定该物体为动态物体。

在识别出动态物体后,根据背景A及静态物体 $\{B_s\}$ 上的特征点重新计算重投影误差,得到精确的位姿估计;然后,将该精确位姿传递至分割模块,利用精确的位姿估计实现对语义分割的优化。

在vSLAM 模块中创建并维护两个地图:跟踪地图和长期地图。跟踪地图用于跟踪过程中计算相机的轨迹,利用精确的位姿估计将背景特征点和静态物体特征点添加进跟踪地图中。而长期地图是用于长期使用的,如回环检测等,因此需要将更加稳定的特征点添加进长期地图中,在本系统中只考虑背景中的特征点。

3.4 Refinement of Segmentation Result

利用前一帧图片的精确位姿估计 $(R_f, T_f)$ 和分割结果,结合当前帧的初始位姿估计 $(R_c, T_c)$ 可以实现对当前帧分割结果的优化。

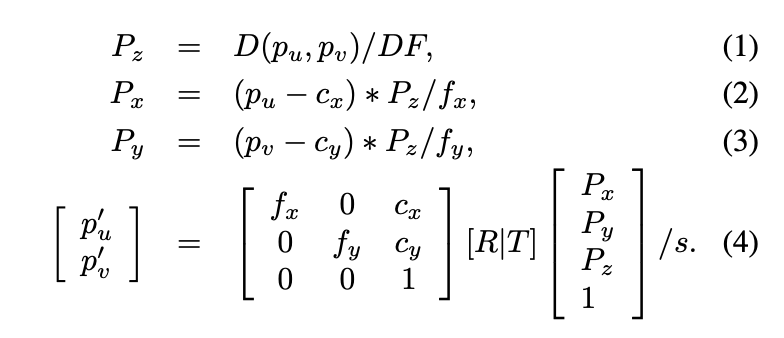

将前一帧分割区域的每个点 $(p_u, p_v)$ 投影至当前帧 $(p_u’, p_v’)$ 处,转换过程如下所示:

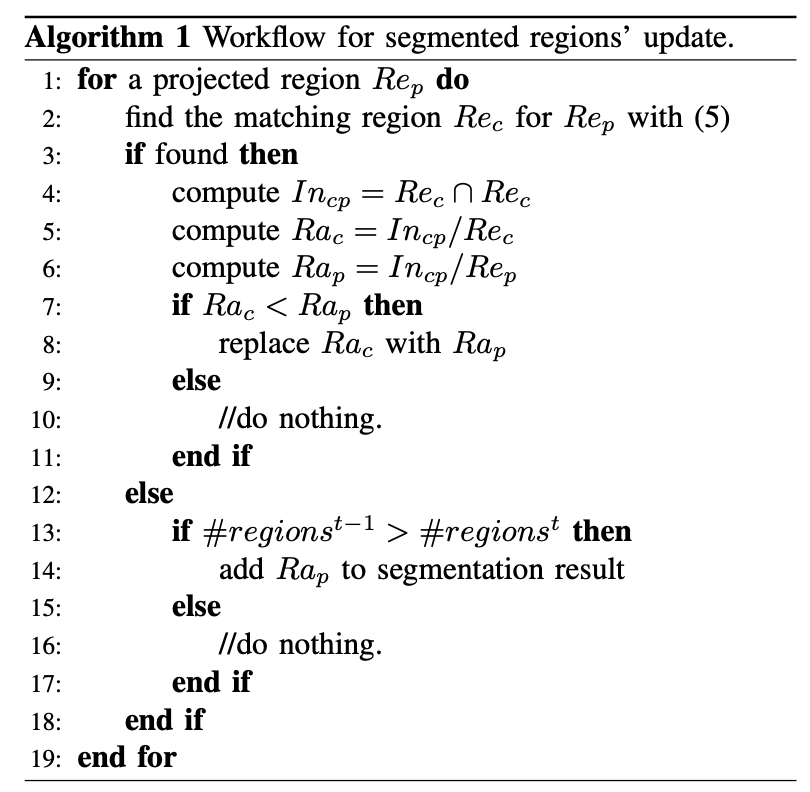

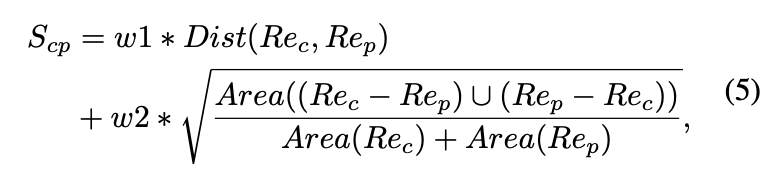

其中,$R = R_c^{-1}R_f, T = T_f - T_x$ 代表两帧之间的相对位姿变换。然后采用如下策略实现对当前帧初始位姿估计的优化,值得注意的是,本策略的前提是基于连续两帧图片不会发生剧烈改变的假设。