Cui, Linyan, and Chaowei Ma. “SOF-SLAM: A Semantic Visual SLAM for Dynamic Environments.” IEEE Access 7 (2019): 166528–39. https://doi.org/10.1109/ACCESS.2019.2952161.

简介

无论是DynaSLAM还是DS-SLAM,它们都是简单地将先验语义信息和几何一致性信息进行“松组合”,即利用语义信息和几何信息分别确定出各自认定的动态特征点,然后采用投票机制对最终的动态特征点进行确认;其中,DynaSLAM 认为只要有一种方法判定一个点属于动态点就认为该点是动态点(OR操作),而DS-SLAM 认为只有两种方法同时认定该点属于动态点才将该点视为动态点(AND操作)。由于动态语义先验信息的不确定性,如人或汽车存在静止的情况,而DynaSLAM所代表的方法会剔除掉大量静态特征点,导致位姿估计精度下降,甚至在部分场景中由于特征点的缺少导致解算失败;同时,语义分割存在准确度不够的情况,如物体边缘部分的分割效果较差,DS-SLAM 代表的方法可能会保留实际的动态特征点,从而导致位姿估计精度下降。

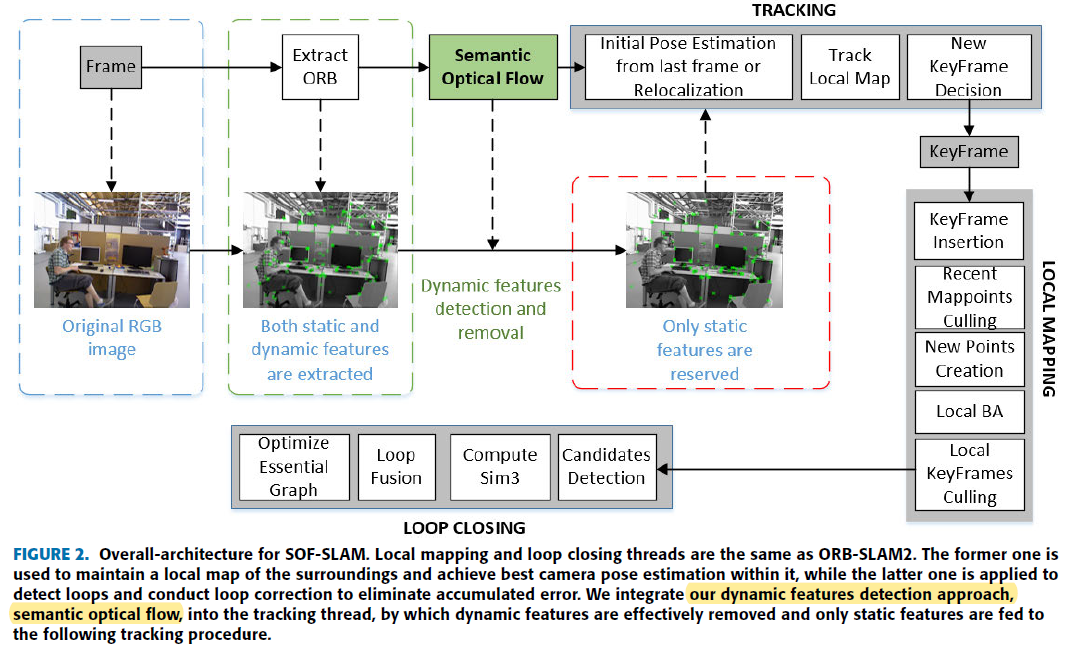

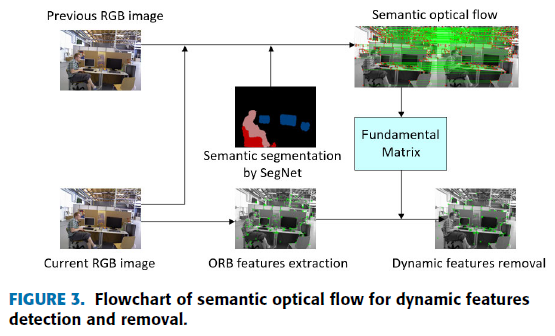

针对以上存在的问题,Cui 等人提出了 SOF-SLAM——Semantic Optical Flow SLAM,一种将语义信息和几何信息进行“紧组合”来实现动态目标检测和剔除的鲁棒SLAM方法;所谓的紧组合指的是利用语义信息来辅助几何信息进行动态物体的探测:作者首先利用语义分割结果去除掉场景中动态物体和潜在动态物体上的特征点,仅利用高可能性静态物体上的特征点进行基础矩阵的求解,进而利用该可靠性更高的基础矩阵应用对极几何理论实现对动态特征点的剔除,从而实现更为鲁棒可靠的动态特征点剔除方法;最终,作者在公开数据集和真实场景中进行了测试,证明了本方法较ORB-SLAM2以及其他语义SLAM算法的优势。